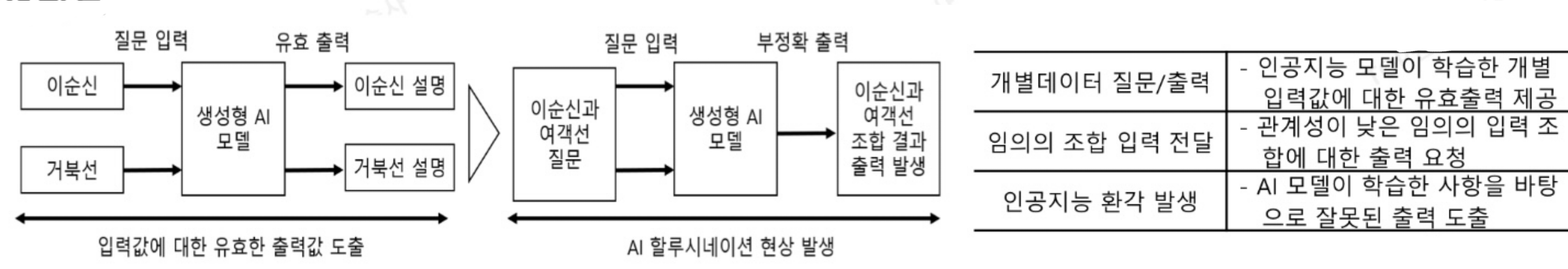

인공지능(AI)에서 환각(hallucination,할루시네이션) 또는 인공 환각(artificial hallucination)은 트레이닝 데이터를 통해 판단하지 않는 것처럼 비쳐지는 AI에 의한 확신적 답변이다. 이러한 오류는 불충분한 학습 데이터, 모델의 잘못된 가정, 모델 학습에 사용된 데이터의 편향 등 다양한 요인으로 인해 발생할 수 있습니다

AI 할루시네이션은 어떻게 발생할까요?

AI 모델은 데이터로 학습되며 데이터에서 패턴을 발견하여 예측하는 방법을 학습합니다. 그러나 이러한 예측의 정확성은 학습 데이터의 품질과 완전성에 따라 달라지는 경우가 많습니다. 1)학습 데이터가 불완전하거나 편향되거나 결함이 있는 경우 AI 모델이 잘못된 패턴을 학습하여 부정확한 예측이나 할루시네이션을 초래할 수 있습니다.

예를 들어 의료 이미지의 데이터 세트로 학습된 AI 모델은 암세포를 식별하는 방법을 학습할 수 있습니다. 그러나 데이터 세트에 정상 조직의 이미지가 포함되어 있지 않으면 정상 조직이 암에 걸렸다고 AI 모델이 잘못 예측할 수 있습니다.

결함이 있는 학습 데이터는 AI 할루시네이션이 발생할 수 있는 이유 중 하나일 뿐입니다. 또 다른 요인은 2)적절한 그라운딩 부족입니다. AI 모델은 실제 지식, 물리적 속성 또는 사실에 기반한 정보를 정확하게 이해하는 데 어려움을 겪을 수 있습니다. 이러한 그라운딩의 결여로 인해 모델이 타당해 보이지만 실제로는 부정확하거나 관련이 없거나 잘못된 출력을 생성할 수 있습니다.

할루시네이션 가능성 최소화 방안

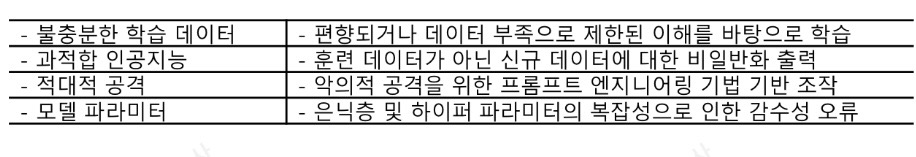

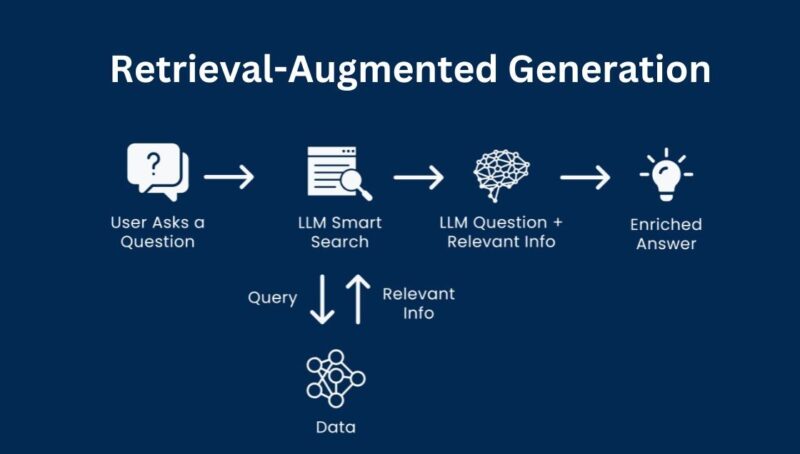

이 문제 해결을 위해 검색증강생성(RAGㆍRetrieval Augmented Generation)’이라는 기술을 적극 적용한다. 정확한 답변을 위해 필요한 레퍼런스를 제공함으로써 LLM의 환각 가능성을 최소화하는 방식이다.

'최신기술' 카테고리의 다른 글

| [042]데이터 패브릭(Data Fabric)이란 무엇인가? (0) | 2024.08.30 |

|---|---|

| [038] 인간처럼 사고하는 멀티모달(Multi Modal) AI란 무엇인가? (0) | 2024.08.26 |

| [033] 빌려 쓰는 AI 서비스(AI as a Service)란 무엇인가? (0) | 2024.08.21 |

| [032]AutoML(Automated Machine Learning)이란 무엇인가? (0) | 2024.08.20 |

| [030]적응형 AI란 무엇인가? (0) | 2024.08.18 |